‘Deepfakes’ pornos para acallar a las mujeres

Las caras de actrices y activistas famosas son reproducidas con inteligencia artificial en cuerpos que no son los suyos en un intento, según los expertos, de expulsarlas de los debates públicos

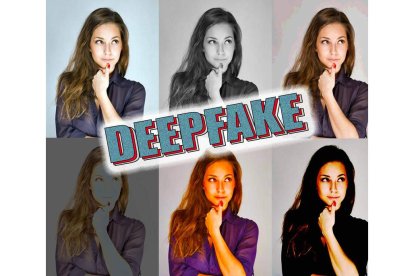

La inteligencia artificial es capaz de reemplazar las caras en otros cuerpos. DL

Un lugar sombrío en internet esconde miles de videos pornográficos donde las protagonistas son famosas como Taylor Swift o Mila Kunis. A pesar de que en las imágenes aparezcan sus rostros, el cuerpo no es el suyo. Como muñecas, fueron creadas con inteligencia artificial, con un software que reemplazó la cara de una actriz porno por la de las artistas.

Se trata de deepfakes , creaciones digitales hechas con algoritmos que aprenden a base de la repetición y que después de codificar decenas de imágenes de rostros desde diferentes ángulos pueden sustituir la cara y la voz de una persona por la de otra.

No tienen por qué ser perniciosos, se usan también en la industria del cine o en la publicidad, pero la compañía Sensity AI estima que entre el 90% y el 95% de todos los deepfakes en línea son pornografía y alrededor del 90% incluye a mujeres.

En ese patio trasero virtual, la gran mayoría de usuarios anónimos utiliza las caras de actrices o cantantes famosas. Aun así, las víctimas también son políticas o activistas.

Efe recibió en noviembre un deepfake de la activista Greta Thunberg que mostraba a la joven de 18 años gesticulando y bailando desnuda. El vídeo estaba circulando en Brasil por WhatsApp e iba acompañado de un mensaje que la acusaba de «estar probando nuevas tácticas en contra del cambio climático».

Con una búsqueda en internet, Efe encontró el vídeo de la actriz original a quien habían reemplazado la cara por la de Thunberg.

Catalina Moreno, de Fundación Karisma, organización colombiana que trabaja en la promoción de los derechos humanos en el mundo digital, señala que este tipo de deepfakes buscan «silenciar, evitar que haya mujeres visibles y en debates públicos».

En el caso de Thunberg, añade la experta, el deepfake quiere «cuestionar si su activismo en medioambiente es creíble teniendo en cuenta que hay un video circulando de ella desnuda» y «dejar su discurso en un segundo plano, quitarle interés a la lucha que está adelantando».

La periodista de investigación india Rana Ayyub explica en un artículo cómo, tras criticar a la India por una violación en Cachemira de una niña de 8 años, empezó a circular un deepfake pornográfico en el que aparecía su rostro y por el que sufrió ciberacoso en las redes.

Las consecuencias a la larga, añade, fueron problemas mentales y autocensura.

La Organización para las Naciones Unidas (ONU) se pronunció sobre el caso pidiéndole al Gobierno indio que la protegiera del ciberacoso, pero no hubo ninguna repercusión para los autores.